AlphaGo

AlphaGo摘要

強化學習有優勢也有局限。

谷歌旗下人工智慧公司 DeepMind 發布了一篇新論文,它講述了團隊如何利用 AlphaGo 的機器學習系統,構建了新的項目 AlphaZero。AlphaZero 使用了名為「強化學習」(reinforcement learning)的 AI 技術,它只使用了基本規則,沒有人的經驗,從零開始訓練,橫掃了棋類遊戲AI。

AlphaZero 首先征服了圍棋,又完爆其他棋類遊戲:相同條件下,該系統經過 8 個小時的訓練,打敗了第一個擊敗人類的 AI——李世石版 AlphaGo;經過 4 個小時的訓練,打敗了此前最強西洋棋 AI Stockfish,2 個小時打敗了最強將棋(又稱日本象棋)AI Elmo。連最強圍棋 AlphaGo 也未能倖免,訓練 34 個小時的 AlphaZero 勝過了訓練 72 小時的 AlphaGo Zero。

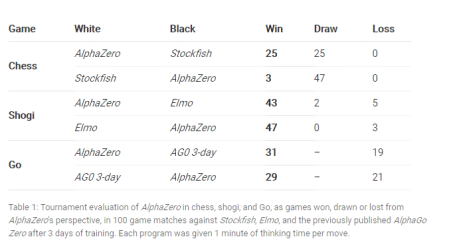

圖/ AlphaZero 視角下,在比賽中贏,平局或輸的局數(來自 DeepMind 團隊論文)

圖/ AlphaZero 視角下,在比賽中贏,平局或輸的局數(來自 DeepMind 團隊論文)強化學習這么強大,它是什麼?

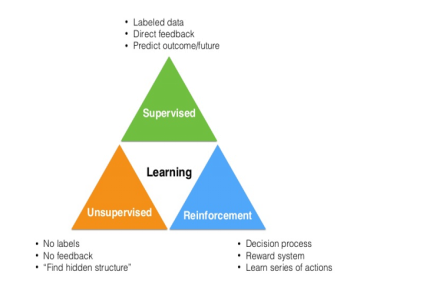

知名 AI 博主 Adit Deshpande 來自加利福尼亞大學洛杉磯分校(UCLA),他曾在部落格中發表過「深度學習研究評論」系列文章,解讀了 AlphaGo 勝利背後的力量。他在文章中介紹到,機器學習領域可以分為三大類:監督學習、無監督學習和強化學習。強化學習可以在不同的情景或者環境下學習採取不同的行動,以此來獲得最佳的效果。

圖/Adit Deshpande 的部落格《Deep Learning Research Review Week 2: Reinforcement Learning》

圖/Adit Deshpande 的部落格《Deep Learning Research Review Week 2: Reinforcement Learning》我們想像一個小房間裡的一個小機器人。我們沒有編程這個機器人移動或走路或採取任何行動。它只是站在那裡。我們希望它移動到房間的一個角落,走到那裡會得到獎勵分數,每走一步將會損失分數。我們希望機器人儘可能到達指定地點,機器人可以向東、南、西、北四個方向運動。機器人其實很簡單,什麼樣的行為最有價值呢,當然是指定地點。為了獲得最大的獎勵,我們只能讓機器人採用最大化價值的行動。

圖/Adit Deshpande 的部落格《Deep Learning Research Review Week 2: Reinforcement Learning》

圖/Adit Deshpande 的部落格《Deep Learning Research Review Week 2: Reinforcement Learning》AlphaZero 完爆棋類遊戲AI,它的價值有多大?

AlphaGo Zero 是個突破性的進展,AlphaZero 也是嗎?國外專家分析,後者在技術上有四點突破:

一、AlphaGo Zero 根據勝率進行最佳化,只考慮勝、負兩種結果;而 AlphaZero 則是根據結果進行最佳化,考慮到了平局等可能。

二、AlphaGo Zero 會改變棋盤方向進行強化學習,而 AlphaZero 則不會。圍棋的棋盤是堆成的,而西洋棋和將棋則不是,因此 AlphaZero 更通用。

三、AlphaGo Zero 會不斷選擇勝率最好的版本替換,而 AlphaZero 則只更新一個神經網路,減少了訓練出不好結果的風險。

四、AlphaGo Zero 中搜尋部分的超參數是通過貝葉斯最佳化得到的,選取會對估計結果產生很大影響。而 AlphaZero 所有對弈都重複使用相同的超參數,因此無需針對遊戲進行特定調整。

第四範式資深機器學習架構師塗威威告訴極客公園,AlphaZero 有突破也有局限:

一、DeepMind 這篇論文核心是證明了 AlphaGo Zero 策略在棋類問題上的通用性;在方法上並沒有特別亮眼的地方。AlphaZero 其實是 AlphaGo Zero 策略從圍棋往其他類似棋類遊戲的拓展版,並戰勝了基於其他技術的棋類遊戲 AI,它們在此之前是最好的。

二、AlphaZero 也只是解決規則明確、完美信息博弈的類似棋類遊戲的「通用」引擎,對於更複雜的其他問題,AlphaZero 依然會遇到困難。

此前,曠世科技孫劍解讀 AlphaGo Zero 時曾表示,「強化學習就算可以擴展很多別的領域,用到真實世界中也沒有那么容易。比如說強化學習可以用來研究新藥品,新藥品很多內部的結構需要通過搜尋,搜尋完以後製成藥,再到真正怎么去檢驗這個藥有效,這個閉環代價非常昂貴,非常慢,你很難像下圍棋這么簡單做出來。」

三、AlphaZero 也需要非常多的計算資源才能解決相對更為「簡單」的棋類問題,成本非常高。據極客公園了解,DeepMind 在論文中稱,他們使用了 5000 個第一代 TPU 生成自對弈棋譜,並用了 64 個第二代 TPU 來訓練神經網路。此前有專家向某媒體表示,TPU 雖然性能很驚艷,但是成本也會很高,有某國際風投機構的投資人對此還發過朋友圈,其中的一句話就是:「這么貴的晶片,我也就是看看......」

四、目前的 AlphaZero 在圍棋上離「圍棋上帝」可能還有距離,贏了人不代表就是上帝,目前的網路結構、訓練策略是不是最優的,其實還是值得進一步研究的。

雖然有一定的局限,但其套用場景值得深挖。在讓機器學習更為通用的研究方向上,有很多其他研究領域值得關注,比如 AutoML、遷移學習等等。同時,如何進一步以更少的代價(計算代價、領域專家代價)獲得更為通用的 AI 引擎,讓 AI 在實際套用中產生更大的價值也是非常值得關注的。

滴滴出行就是一個特別的領域,據極客公園了解,滴滴在匹配司機和乘客的過程中,就使用了人工智慧技術,從不合理的直線距離匹配(可能隔著河),到指派到乘客處用時最少的車,經歷了很多技術最佳化。他們也遇到了問題,並為之努力:在訓練人工智慧系統時,可以使用 GPU 集群等技術,但當讓司機和乘客匹配時,要求實時性,配置也會降低,因此如何保證準確,也是研究人員一直在探討的問題。

但塗威威對 DeepMind 在「通用人工智慧」方向上的努力表示肯定。

圖 / 北大AI公開課《胡郁:人工智慧+,共創新時代》

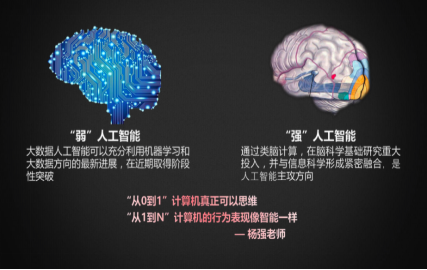

圖 / 北大AI公開課《胡郁:人工智慧+,共創新時代》第四範式首席科學家、國際人工智慧協會(IJCAI)主席、香港科技大學計算機系系主任楊強教授曾提到,計算機真正可以思維的「強」人工智慧(通用人工智慧)其實是想實現「從 0 到 1」的突破,而目前包括工業界和計算機套用學科等領域,其實只是想讓計算機的行為表現像智慧型一樣,這可以稱為「從1 到 N」。

但是,科學家們一直在不斷探索通用人工智慧。DeepMind 就是這方面的先行者之一,好像登山一樣,只要一步步攀登,有一天人類必然登頂。

AlphaGo AI 機器學習系統 AlphaZero