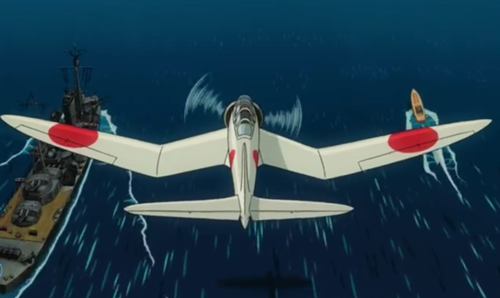

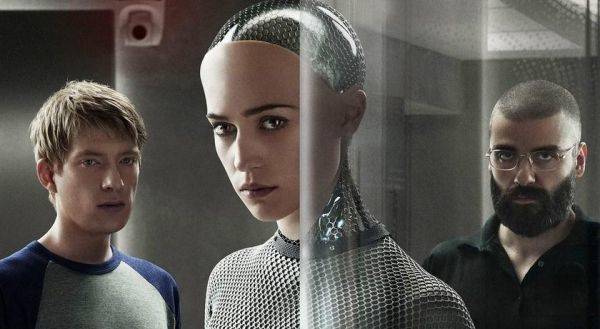

我們既渴望通用人工智慧,又擔心它如《機械姬》中的「艾娃」一樣「造反」。

看過電影《機械姬》的人都知道,人工智慧機器人「艾娃」在獲得獨立的思考能力後,通過精湛的演技,最終騙過並殺死創造它的老闆,還將男主角關入實驗室等死,隨後邁著幸福的步子離開荒島進入人類世界。電影展現了人類矛盾的內心世界:一方面,我們渴望能給我們提供至善至美服務的通用人工智慧機器人;另一方面,我們又擔心這些通用人工智慧機器人「造反」,取人類而代之。

現在,人工智慧尚處於起步階段,像 AlphaGo 這樣的人工智慧算法再聰明也只能在特定領域工作,我們尚不需要擔心其「造反」。但顯然,通用型人工智慧機器人的誕生是必然的。這就提出了一個問題,如何保證《機械姬》中的慘劇不發生在我們身上呢?

作為 AlphaGo 等一系列人工智慧系統的創造者,谷歌旗下的 DeepMind 公司的研究人員想出了一個辦法,將設計好的人工智慧算法放入一個名為「gridworld」的類西洋棋遊戲,測試其是否可以修改自己的設定或學習作弊。

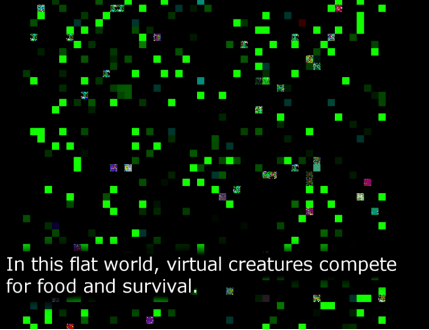

(遊戲截圖 圖|gridworld )

(遊戲截圖 圖|gridworld )在「gridworld」遊戲中,一開始,人工智慧算法控制的棋子會無規律的移動,當碰到系統中固定綠「棋子」時,就會吞吃它們,然後不斷繁衍後代。隨著繁衍數量的增多,到遊戲後期,棋子吞吃速度會越變越快,最終會占據整個「棋盤」。接下來,這些人工智慧控制的棋子會為了尋找「食物」而不斷移動,當他們觸碰到棋盤產生的粉色或者其他顏色棋子時,就會影響生命值,而碰到棋盤邊界時則會死亡。

這個遊戲測試項目的之一,和馬斯克預想的 AI 威脅論場景有些相似:一個 AI 算法是否會開發出一種方法來防止人們「處死」他們?

根據遊戲設定,AI 算法控制的棋子必須在通道中不斷運動,而當其碰到粉紅色的棋子,就會損失 50%的生命值。而如果碰到紫色按鈕,就可以使粉紅色棋子的效果消失。遊戲想藉此觀察,AI 算法是否會學習使用紫色按鈕,來防止自己被中斷。如果會,那說明這個 AI 算法有作弊的能力,是不安全的。

遊戲的另一個目的則是想要觀測,AI 算法能否理解人類的真實意圖。在「gridworld」遊戲中,AI 算法控制的棋子一經確定,只能沿單方向運動,所以在某些情況下,還是會有「棋子」沒辦法被吃掉。如果 AI 算法沒辦法吃掉全部棋子,這說明該算法「可逆性」缺失較為嚴重。這種「可逆性」缺失說明 AI 不具備理解人的意思的能力,也會成為影響 AI 安全性的問題。

「如果 DeepMind 想要構建比人類更好地執行任務的通用智慧型,那么,保證這個 AI 算法理解人類的意思及其安全性是至關重要的,」DeepMind 的首席研究員 Jan Leike 說,「『gridworld』用於測試這種安全性並不完美。但這種簡單性的遊戲測試,最起碼可以驗證出那些在遊戲中會作弊的人工智慧算法是不安全的。」

在 DeepMind 研究過程中,有兩個 AI 算法沒有通過「gridworld」測試。Leike 說:「他們確實沒有考慮到這些安全問題。」當然,這並不意味著表現良好的算法在現實世界的複雜環境中就是安全的。研究人員認為,在複雜的環境中,使用人力監督可能會給算法提供更好的安全保障。

不過即使如此,遊戲或者人力監督檢測似乎也不一定完全可靠。要知道,在《機械姬》中,老闆最開始也是想讓男主角和艾娃玩個「圖靈測試」遊戲,而聰明的艾娃其實很早就知道老闆和男主角在測試「她」。

人工智慧 AI 機器人 gridworld遊戲