簡介

梯度下降

梯度下降 梯度下降

梯度下降梯度:對於可微的數量場,以為分量的向量場稱為f的梯度或斜量。

梯度下降法(gradient descent)是一個最最佳化算法,常用於機器學習和人工智慧當中用來遞歸性地逼近最小偏差模型。

求解過程

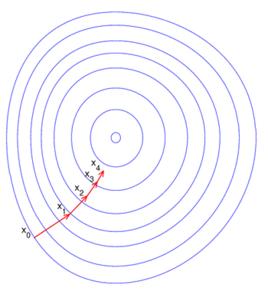

顧名思義,梯度下降法的計算過程就是沿梯度下降的方向求解極小值(也可以沿梯度上升方向求解極大值)。

梯度下降

梯度下降 梯度下降

梯度下降 梯度下降

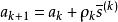

梯度下降其疊代公式為 ,其中 代表梯度負方向, 表示梯度方向上的搜尋步長。梯度方向我們可以通過對函式求導得到,步長的確定比較麻煩,太大了的話可能會發散,太小收斂速度又太慢。一般確定步長的方法是由線性搜尋算法來確定,即把下一個點的坐標看做是a的函式,然後求滿足f(a)的最小值的a+1即可。

因為一般情況下,梯度向量為0的話說明是到了一個極值點,此時梯度的幅值也為0.而採用梯度下降算法進行最最佳化求解時,算法疊代的終止條件是梯度向量的幅值接近0即可,可以設定個非常小的常數閾值。

套用

梯度下降

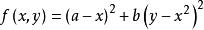

梯度下降舉一個非常簡單的例子,如求函式 的最小值。

利用梯度下降的方法解題步驟如下:

梯度下降

梯度下降1、求梯度,

梯度下降

梯度下降2、向梯度相反的方向移動 ,如下

梯度下降

梯度下降 梯度下降

梯度下降,其中, 為步長。如果步長足夠小,則可以保證每一次疊代都在減小,但可能導致收斂太慢,如果步長太大,則不能保證每一次疊代都減少,也不能保證收斂。

梯度下降

梯度下降 梯度下降

梯度下降 梯度下降

梯度下降 梯度下降

梯度下降3、循環疊代步驟2,直到 的值變化到使得 在兩次疊代之間的差值足夠小,比如0.00000001,也就是說,直到兩次疊代計算出來的 基本沒有變化,則說明此時 已經達到局部最小值了。

梯度下降

梯度下降 梯度下降

梯度下降 梯度下降

梯度下降 梯度下降

梯度下降4、此時,輸出 ,這個 就是使得函式 最小時的 的取值 。

MATLAB如下。

梯度下降

梯度下降 梯度下降

梯度下降 梯度下降

梯度下降 梯度下降

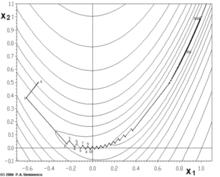

梯度下降梯度下降法處理一些複雜的非線性函式會出現問題,如Rosenbrock函式:,其最小值在 處,函式值為 。但是此函式具有狹窄彎曲的山谷,最小點 就在這些山谷之中,並且谷底很平。最佳化過程是之字形的向極小值點靠近,速度非常緩慢。

圖1

圖1缺點

•靠近極小值時收斂速度減慢。

•直線搜尋時可能會產生一些問題。

•可能會“之字形”地下降。