簡介

在模式識別中, 費雪線性判別(Fisher's linear discriminant)是一種線性判別方法,其意圖是將d維空間中的數據點投影到c-1維空間上去,使得不同類的樣本點在這個空間上的投影儘量分離,同類的儘量緊湊。

兩類情況

費雪線性判別

費雪線性判別 費雪線性判別

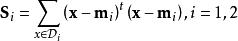

費雪線性判別在二類判別時,費雪線性判別將 d維空間中的數據點投影到一條直線上去,使得不同類的樣本點在這條直線上的投影儘量分離,同類的樣本點在這條直線上儘量緊湊。假設有兩類樣本集的類別為 ω,樣本數為 n,的類別為 ω,樣本數為 n。定義樣本均值 m和類內散布 S。

費雪線性判別

費雪線性判別 費雪線性判別

費雪線性判別 費雪線性判別

費雪線性判別投影直線的方向向量為 w,樣本投影在直線上的值為 y。則可得兩類樣本投影后的均值和類內散布為, i=1,2。

費雪線性判別

費雪線性判別在兩個類別的分布是多元常態分配,且協方差矩陣相同時,根據貝葉斯決策理論,,並且 w是一個與 w和先驗機率有關的常數。我們可以用樣本均值與樣本協方差去估計 u和 Σ。更一般地說,如果我們對投影后的數據進行平滑,或用一維高斯函式進行擬合, ω就位於使兩類的後驗機率相同的位置上。

多類情況

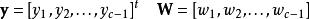

費雪線性判別在面對二類判別時,將兩類樣本向一條直線投影,也就是將數據從d維空間向1維空間投影。這樣在面對c個類的判別時,所要做就是將數據從d維空間向c-1維空間投影。這就需要推廣投影方程、類間散布矩陣 S和類內散布矩陣 S。從d維空間向c-1維空間的投影是通過c-1投影方程進行的:

費雪線性判別

費雪線性判別 費雪線性判別

費雪線性判別 費雪線性判別

費雪線性判別這裡的為第i類的樣本集。設,c-1個方程可以更簡練地表達:

費雪線性判別

費雪線性判別 費雪線性判別

費雪線性判別 費雪線性判別

費雪線性判別這裡的為第i類的樣本的投影向量集。類間散布矩陣 S和類內散布矩陣 S可以由總體散布矩陣 S和總體均值向量 m推導得到:

費雪線性判別

費雪線性判別可以證明,當 W的列向量 w是的廣義特徵向量時,可以使得 J( w)最大。因為 S中c個秩為1或0的矩陣相加,而且其中只有c-1個矩陣是相互獨立的。所以 S的秩最多為c-1。所以最多只有c-1個特徵向量是非零的。

套用

人臉識別

在人臉識別中,每一個人臉圖像具有大量的像素點。LDA主要用來將特徵減少到一個可以處理的數目在進行分類。每一個新的維度都是原先像素值的線性組合,這就構成了一個模板。這樣獲得的線性組合被稱為Fisher faces,而通過主成分分析獲得的則稱為特徵臉。