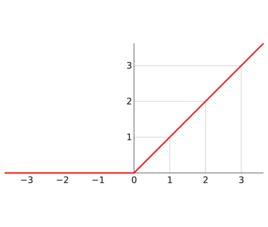

定義

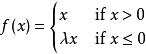

通常意義下,線性整流函式指代數學中的斜坡函式,即

線性整流函式

線性整流函式 線性整流函式

線性整流函式 線性整流函式

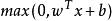

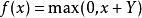

線性整流函式而在神經網路中,線性整流函式作為神經元的激活函式,定義了該神經元線上性變換 之後的的非線性輸出結果。換言之,對於進入神經元的來自上一層神經網路的輸入向量 ,使用線性整流激活函式的神經元會輸出

線性整流函式

線性整流函式至下一層神經元或作為整個神經網路的輸出(取決現神經元在網路結構中所處位置)。

變種

線性整流函式在基於斜坡函式的基礎上有其他同樣被廣泛套用於深度學習的變種,譬如帶泄露線性整流(Leaky ReLU), 帶泄露隨機線性整流(Randomized Leaky ReLU),以及噪聲線性整流(Noisy ReLU).

帶泄露線性整流

線性整流函式

線性整流函式 線性整流函式

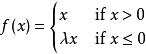

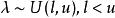

線性整流函式在輸入值為負的時候, 帶泄露線性整流函式(Leaky ReLU)的梯度為一個常數,而不是0。在輸入值為正的時候,帶泄露線性整流函式和普通斜坡函式保持一致。換言之,

線性整流函式

線性整流函式 線性整流函式

線性整流函式在深度學習中,如果設定為一個可通過反向傳播算法(Backpropagation)學習的變數,那么帶泄露線性整流又被稱為 參數線性整流(Parametric ReLU)。

帶泄露隨機線性整流

線性整流函式

線性整流函式 線性整流函式

線性整流函式帶泄露隨機線性整流(Randomized Leaky ReLU, RReLU)最早是在Kaggle全美數據科學大賽(NDSB)中被首先提出並使用的。相比於普通帶泄露線性整流函式,帶泄露隨機線性整流在負輸入值段的函式梯度是一個取自連續性均勻分布機率模型的隨機變數,即

線性整流函式

線性整流函式 線性整流函式

線性整流函式 線性整流函式

線性整流函式其中且。

噪聲線性整流

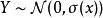

噪聲線性整流(Noisy ReLU)是修正線性單元在考慮高斯噪聲的基礎上進行改進的變種激活函式。對於神經元的輸入值{\displaystyle x},噪聲線性整流加上了一定程度的常態分配的不確定性,即

線性整流函式

線性整流函式 線性整流函式

線性整流函式其中隨機變數。當前噪聲線性整流函式在受限玻爾茲曼機(Restricted Boltzmann Machine)在計算機圖形學的套用中取得了比較好的成果。

優勢

相比於傳統的神經網路激活函式,諸如邏輯函式(Logistic sigmoid)和tanh等雙曲函式,線性整流函式有著以下幾方面的優勢:

線性整流函式

線性整流函式仿生物學原理:相關大腦方面的研究表明生物神經元的信息編碼通常是比較分散及稀疏的。通常情況下,大腦中在同一時間大概只有1%-4%的神經元處於活躍狀態。使用線性修正以及正則化(regularization)可以對機器神經網路中神經元的活躍度(即輸出為正值)進行調試;相比之下,邏輯函式在輸入為0時達到,即已經是半飽和的穩定狀態,不夠符合實際生物學對模擬神經網路的期望。不過需要指出的是,一般情況下,在一個使用修正線性單元(即線性整流)的神經網路中大概有50%的神經元處於激活態。

更加有效率的梯度下降以及反向傳播:避免了梯度爆炸和梯度消失問題。

簡化計算過程:沒有了其他複雜激活函式中諸如指數函式的影響;同時活躍度的分散性使得神經網路整體計算成本下降。