定義

網路正則是一種控制過擬合手段,即通過對網路參數添加正則項。正則項在最佳化過程中層的參數或層的激活值添加懲罰項,這些懲罰項將與損失函式一起作為網路的最終最佳化目標。

常見的正則項有1範數、2範數、1+ 2約束(Elastic Net約束)等。正則化可以看作一種先驗假設,如1範數對應於參數的拉普拉斯分布假設,2約束對應於參數的高斯分布假設。可以看到,在為損失函式增加()約束項後,那些違背先驗假設的參數將會產生較大的懲罰值,因此在最佳化過程中網路的參數會朝著先驗假設的方向更新。例如,當為網路施加2約束時,具有較大值的參數經過平方後會產生一個很大的數值,不利於目標函式的最小化。因此在網路最佳化的過程中,參數將避免出現極大或極小的值。參數的值趨向於常態分配時,接近0值的參數較多,模型的複雜度趨於簡單,因此能夠達到控制過擬合的目的。正則化方法不但適用於神經網路,也適用於大多數機器學習模型。

過擬合

機器學習的基本問題是利用模型對數據進行擬合,學習的目的並非是對有限訓練集進行正確預測,而是對未曾在訓練集合中的樣本能夠正確預測。模型對訓練集數據的誤差稱為經驗誤差,對測試集數據的誤差稱為泛化誤差。模型對訓練集以外樣本的預測能力就稱為模型的泛化能力,追求這種泛化能力始終是機器學習的目標。

過擬合和欠擬合是導致模型泛化能力不高的兩種常見原因,都是模型學習能力與數據複雜度之間失配的結果。“欠擬合”常常在模型學習能力較弱,而數據複雜度較高的情況出現,此時模型由於學習能力不足,無法學習到數據集中的“一般規律”,因而導致泛化能力弱。與之相反,“過擬合”常常在模型學習能力過強的情況出現,此時的模型學習能力太強,以至於將訓練集單個樣本自身的特點都能捕捉到,並將其認為是“一般規律”,同樣這種情況也會導致模型泛化能力下降。過擬合與欠擬合的區別在於,欠擬合在訓練集和測試集上的性能都較差,而過擬合往往能學習訓練集數據的性質,而在測試集上的性能較差。解決方法:

(1)在神經網路模型中,可使用權值衰減的方法,即每次疊代過程中以某個小因子降低每個權值。

(2)選取合適的停止訓練標準,使對機器的訓練在合適的程度;

(3)保留驗證數據集,對訓練成果進行驗證;

(4)獲取額外數據進行交叉驗證;

(5)正則化,即在進行目標函式或代價函式最佳化時,在目標函式或代價函式後面加上一個正則項,一般有L1正則與L2正則等。

深度學習

深度學習是機器學習的一項分支,是一類由大數據推動,以多層人工神經網路為表現形式,以特徵提取為主要目的的算法,既可以用於監督學習,也可以用於非監督學習。我們將深度學習的特性總結如下:

一是計算密集。深度學習的一般形式是多層的人工神經網路,一個深度學習模型往往含有數以百萬計甚至千萬計的參數,龐大的模型必須有大量的訓練樣本作為支撐才能抑制過擬合,提高泛化能力。儘管有一些工作試圖降低深度學習所需要的樣本數,但總體而言,沒有大量的數據支撐,深度學習就無從談起。網路規模和數據量兩方面共同決定深度學習具有計算密集的特性。

二是特徵的自動提取和分層處理,深度神經網路主要處理的問題是從數據中自動提取特徵。這種特徵的提取是通過逐層組合抽象完成的,具有分層特性。網路的底層(近輸入端)抽取的是局部的,低級的特徵,這些特徵經過逐層組合和非線性變換,在高層(遠輸入端)形成全局和抽象的特徵。特徵的語義性從低到高得到逐漸加強。

三是工程性強,可解釋性弱。儘管在深度學習的理論方面已經有許多有意義的工作,但深度學習的原理尚不明確,在大多數情況下深度學習仍然像是一個“黑盒子”,缺乏嚴格的理論證明。另一方面,深度學習是一門工程性非常強的學科,神經網路的編程、調參、最佳化都具有很強的實踐性,十分依靠工程師的個人經驗。

損失函式

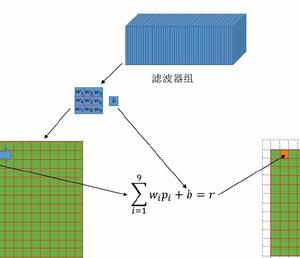

損失函式(loss function)是用來估量你模型的預測值f(x)與真實值Y的不一致程度,它是一個非負實值函式,通常使用L(Y, f(x))來表示,損失函式越小,模型的魯棒性就越好。損失函式是經驗風險函式的核心部分,也是結構風險函式重要組成部分。模型的結構風險函式包括了經驗風險項和正則項。

在統計學,統計決策理論和經濟學中,損失函式是指一種將一個事件(在一個樣本空間中的一個元素)映射到一個表達與其事件相關的經濟成本或機會成本的實數上的一種函式。更通俗地說,在統計學中損失函式是一種衡量損失和錯誤(這種損失與“錯誤地”估計有關,如費用或者設備的損失)程度的函式。