什麼是激活函式

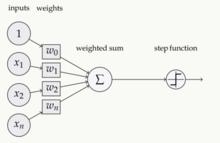

圖1

圖1激活函式(Activation functions)對於人工神經網路 模型去學習、理解非常複雜和非線性的函式來說具有十分重要的作用。它們將非線性特性引入到我們的網路中。如圖1,在神經元中,輸入的 inputs 通過加權,求和後,還被作用了一個函式,這個函式就是激活函式。引入激活函式是為了增加神經網路模型的非線性。沒有激活函式的每層都相當於矩陣相乘。就算你疊加了若干層之後,無非還是個矩陣相乘罷了。

為什麼要用激活函式

如果不用激活函式,每一層輸出都是上層輸入的線性函式,無論神經網路有多少層,輸出都是輸入的線性組合,這種情況就是最原始的感知機(Perceptron)。

如果使用的話,激活函式給神經元引入了非線性因素,使得神經網路可以任意逼近任何非線性函式,這樣神經網路就可以套用到眾多的非線性模型中。

常用的激活函式

Sigmoid函式

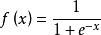

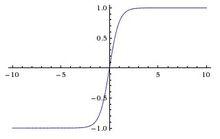

Sigmoid函式是一個在生物學中常見的S型函式,也稱為S型生長曲線。在信息科學中,由於其單增以及反函式單增等性質,Sigmoid函式常被用作神經網路的閾值函式,將變數映射到0,1之間 。公式如下

激活函式

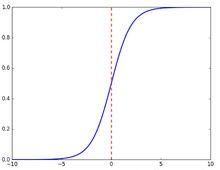

激活函式函式圖像如下

Sigmoid 圖像

Sigmoid 圖像Tanh函式

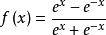

Tanh是雙曲函式中的一個,Tanh()為雙曲正切。在數學中,雙曲正切“Tanh”是由基本雙曲函式雙曲正弦和雙曲餘弦推導而來。公式如下

激活函式

激活函式函式圖像如下

Tanh函式圖像

Tanh函式圖像ReLU函式

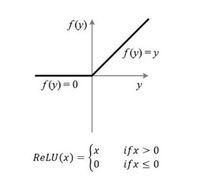

Relu激活函式(The Rectified Linear Unit),用於隱層神經元輸出。公式如下

激活函式

激活函式 ReLU函式圖像

ReLU函式圖像函式圖像如下